Microsoft Translator 為邊緣裝置帶來 AI 翻譯功能

2016 年 11 月,微軟為開發人員和終端使用者帶來了 AI 驅動的機器翻譯(又稱神經機器翻譯(NMT))的好處。上週、 微軟將 NMT 功能帶到雲端邊緣 NPU 是一個整合在電腦中的 AI 專用處理器。 Mate 10, 華為的最新旗艦手機。新晶片讓 AI 驅動的翻譯功能即使在沒有網際網路連線的情況下也能在裝置上使用,使系統所產生的翻譯品質與線上系統不相上下。

為了實現這一突破,來自微軟和華為的研究人員和工程師們通力合作,將神經轉譯適應於這種新的計算環境。

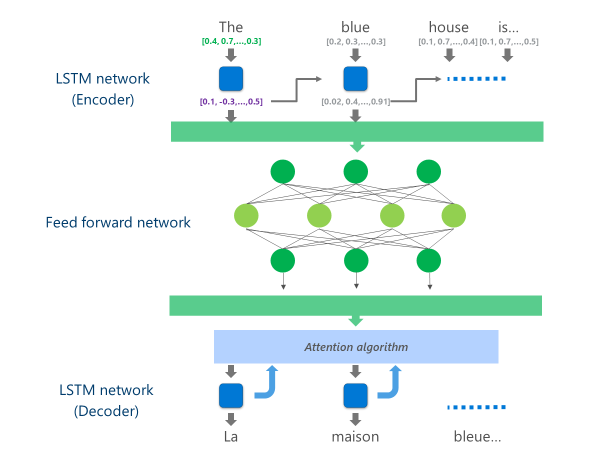

目前投入生產的最先進 NMT 系統 (即企業和應用程式在雲端大規模使用的系統) 都採用結合多層神經網路的架構。 LSTM 網路、注意演算法和轉換 (解碼) 層。

下面的動畫以簡化的方式說明了這種多層神經網路的功能。如需詳細資訊,請參閱 "什麼是機器翻譯頁面"在 Microsoft Translator 網站上。

在此雲端 NMT 實作中,這些中間 LSTM 層消耗了大部分的運算能力。為了能夠在行動裝置上執行完整的 NMT,我們必須找到一種機制,能夠降低這些運算成本,同時盡可能保持翻譯品質。

這就是華為的神經處理單元 (NPU) 發揮作用的地方。 微軟的研究人員和工程師利用專門為低延遲 AI 運算而設計的 NPU,來卸載在主 CPU 上處理速度會慢到難以接受的作業。

執行

目前在華為 Mate 10 的 Microsoft Translator 應用程式上所提供的實作,可透過將運算最密集的工作卸載至 NPU 來最佳化翻譯。

具體來說,此實作是以一個深層的 FSTM 網路層取代這些中間的 LSTM 網路層。前進神經網路.深度前饋神經網路功能強大,但由於神經元之間的高連結性,需要非常大量的計算。

神經網路主要依賴矩陣乘法,這種運算從數學角度來看並不複雜,但以深度神經網路所需的規模執行時卻非常昂貴。华为 NPU 擅长以大规模并行方式执行这些矩阵乘法。從電力利用的角度來看,它也相當有效率,這是電池供電裝置的重要特質。

在這個前饋網路的每一層,NPU 都會計算原始神經元輸出和後續的 ReLu 啟動函數 高效且延遲極低。利用 NPU 上充足的高速記憶體,它可以並行執行這些計算,而無需支付 CPU 和 NPU 之間的資料傳輸成本(即減慢效能)。

一旦計算出這個深度前饋網路的最後一層,系統就有了豐富的來源語句子表徵。然後,這個表徵會透過一個從左至右的 LSTM「解碼器」來產生每個目標語字詞,其注意演算法與 NMT 線上版本所使用的相同。

如 Anthony AueMicrosoft Translator 團隊的首席軟體開發工程師解釋說:"將在資料中心的強大雲端伺服器上執行的系統,原封不動地運行在手機上,並不是一個可行的選擇。行動裝置在運算能力、記憶體和電源使用上都有限制,而雲端解決方案則沒有這些限制。有了 NPU 的存取權,再加上其他一些架構上的調整,讓我們可以繞過許多這些限制,設計出一個可以在裝置上快速、有效率地執行的系統,而不必犧牲翻譯品質。."

在創新的 NPU 晶片組上實作這些翻譯模型,讓微軟和華為能夠提供裝置上的神經翻譯,即使在您離開網路時,其品質仍可媲美雲端系統。