Llevar la traducción AI a los dispositivos Edge con Microsoft Translator

En noviembre de 2016, Microsoft trajo el beneficio de la traducción automática impulsada por IA, también conocida como neural Machine Translation (NMT), a desarrolladores y usuarios finales por igual. La semana pasada Microsoft trajo la capacidad de NMT al borde de la nube aprovechando la NPU, un procesador dedicado a la IA integrado en el Mate 10, El último teléfono insignia de Huawei. El nuevo chip hace que las traducciones con tecnología AI estén disponibles en el dispositivo, incluso en ausencia de acceso a Internet, lo que permite al sistema producir traducciones cuya calidad está a la par con el sistema en línea.

Para lograr este avance, investigadores e ingenieros de Microsoft y Huawei colaboraron en la adaptación de la traducción neuronal a este nuevo entorno informático.

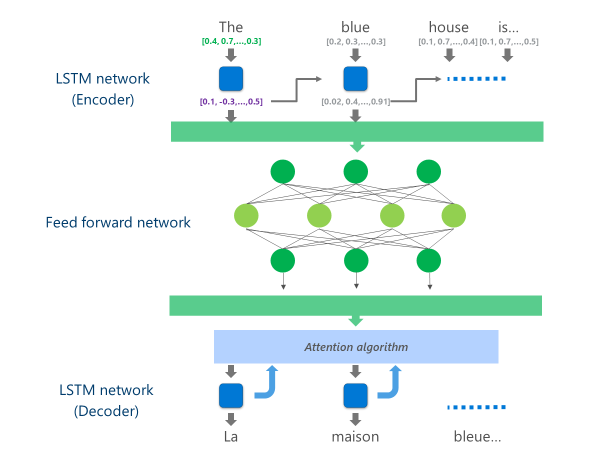

Los sistemas NMT más avanzados actualmente en producción (es decir, utilizados a escala en la nube por empresas y aplicaciones) están utilizando una arquitectura de redes neuronales que combina varias capas de Redes LSTM, un algoritmo de atención y una capa de traducción (decodificador).

La siguiente animación explica, de forma simplificada, cómo funciona esta red neuronal multicapa. Para más detalles, por favor refiérase a la "¿Qué es la página de traducción automática"en el sitio de Microsoft Translator.

En esta implementación de NMT en la nube, estas capas LSTM intermedias consumen gran parte de la potencia de computación. Para poder ejecutar NMT completo en un dispositivo móvil, era necesario encontrar un mecanismo que pudiera reducir estos costes computacionales preservando, tanto como sea posible, la calidad de la traducción.

Aquí es donde entra en juego la unidad de procesamiento neural (NPU) de Huawei. Los investigadores e ingenieros de Microsoft aprovecharon el NPU, que está diseñado específicamente para sobresalir en cálculos de IA de baja latencia, para descargar operaciones que habrían sido inaceptablemente lentas para procesar en la CPU principal.

Implementación

La implementación ahora disponible en la aplicación Microsoft Translator para Huawei mate 10 optimiza la traducción descargando las tareas más intensivas en computación a la NPU.

Específicamente, esta implementación reemplaza estas capas de red LSTM medias por un profundo fEED-Forward red neuronal. Las redes neuronales de avance profundo son potentes, pero requieren grandes cantidades de computación debido a la alta conectividad entre las neuronas.

Las redes neuronales dependen principalmente de las multiplicaciones matriciales, una operación que no es compleja desde un punto de vista matemático, pero muy costosa cuando se realiza a la escala requerida para una red neuronal tan profunda. El Huawei NPU sobresale en la realización de estas multiplicaciones de la matriz de una manera masiva paralela. También es bastante eficiente desde el punto de vista de la utilización de energía, una cualidad importante en los dispositivos alimentados por batería.

En cada capa de esta red de avance, la NPU computa tanto la salida de la neurona cruda como la posterior Función de activación de ReLu de forma eficiente y con una latencia muy baja. Aprovechando la amplia memoria de alta velocidad en la NPU, realiza estos cálculos en paralelo sin tener que pagar el costo de transferencia de datos (es decir, ralentizar el rendimiento) entre la CPU y la NPU.

Una vez que se calcula la capa final de esta red de avance profundo, el sistema tiene una representación enriquecida de la frase de idioma de origen. Esta representación se alimenta a través de un "decodificador" LSTM de izquierda a derecha para producir cada palabra de idioma de destino, con el mismo algoritmo de atención utilizado en la versión en línea del NMT.

Como Anthony Aue, un ingeniero de desarrollo de software principal en el equipo de Microsoft Translator explica: "tomar un sistema que se ejecuta en servidores en la nube potentes en un centro de datos y ejecutarlo sin cambios en un teléfono móvil no es una opción viable. Los dispositivos móviles tienen limitaciones en la potencia de computación, la memoria y el uso de energía que las soluciones en la nube no tienen. Tener acceso a la NPU, junto con algunos otros ajustes arquitectónicos, nos permitió trabajar en torno a muchas de estas limitaciones y diseñar un sistema que se puede ejecutar de forma rápida y eficiente en el dispositivo sin tener que comprometer la calidad de la traducción."

La implementación de estos modelos de traducción en el innovador chipset NPU permitió a Microsoft y Huawei entregar la traducción neuronal en el dispositivo a una calidad comparable a la de los sistemas basados en la nube, incluso cuando usted está fuera de la red.