Apporter la traduction d'ai aux périphériques Edge avec Microsoft Translator

En novembre 2016, Microsoft a apporté l'avantage de la traduction automatique de l'intelligence artificielle, alias neural machine translation (NMT), pour les développeurs et les utilisateurs finaux. La semaine dernière Microsoft a apporté la capacité NMT au bord du nuage en tirant parti de la NPU, un processeur dédié à l'IA intégré dans le Le mate 10, Le dernier téléphone phare de Huawei. La nouvelle puce rend les traductions de l'intelligence artificielle disponibles sur l'appareil, même en l'absence d'accès à Internet, ce qui permet au système de produire des traductions dont la qualité est comparable au système en ligne.

Pour réaliser cette percée, les chercheurs et ingénieurs de Microsoft et Huawei ont collaboré à l'adaptation de la traduction neuronale à ce nouvel environnement informatique.

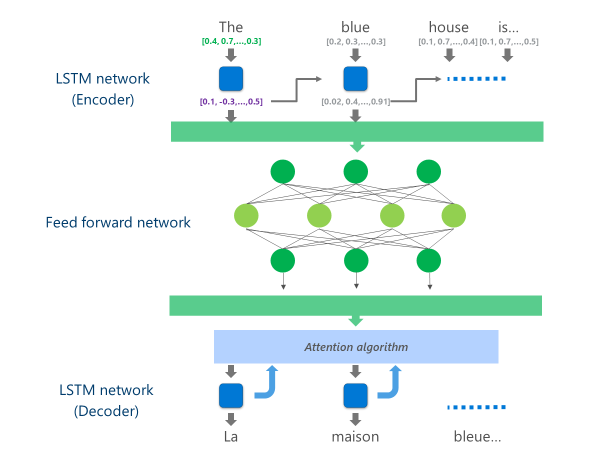

Les systèmes NMT les plus avancés actuellement en production (c.-à-d. utilisés à grande échelle dans le Cloud par les entreprises et les applications) utilisent une architecture de réseau neuronal combinant plusieurs couches de Réseaux LSTM, un algorithme d'attention et une couche de traduction (décodeur).

L'animation ci-dessous explique, de manière simplifiée, comment fonctionne ce réseau neuronal multicouche. Pour plus de détails, veuillez vous référer auce qui est la page de traduction automatique» sur le site Microsoft Translator.

Dans cette implémentation NMT Cloud, ces couches LSTM moyennes consomment une grande partie de la puissance de calcul. Pour pouvoir exécuter le NMT complet sur un appareil mobile, il était nécessaire de trouver un mécanisme qui pourrait réduire ces coûts de calcul tout en préservant, autant que possible, la qualité de la traduction.

C'est là que l'unité de traitement neural (NPU) de Huawei entre en jeu. Les chercheurs et les ingénieurs de Microsoft ont profité de la NPU, qui est spécifiquement conçu pour exceller aux calculs d'IA à faible latence, pour décharger les opérations qui auraient été trop lentes à traiter sur le CPU principal.

Application

L'implémentation désormais disponible sur l'application Microsoft Translator pour Huawei mate 10 optimise la traduction en déchargeant les tâches les plus gourmandes en calcul pour le NPU.

Plus précisément, cette implémentation remplace ces couches de réseau LSTM moyen par un f profondEED-Forward réseau neuronal. Les réseaux neuronaux à avance profonde sont puissants, mais nécessitent de très grandes quantités de calculs en raison de la grande connectivité entre les neurones.

Les réseaux neuronaux reposent principalement sur des multiplications matricielles, une opération qui n'est pas complexe d'un point de vue mathématique mais très coûteuse lorsqu'elle est exécutée à l'échelle requise pour un réseau neuronal aussi profond. Le Huawei NPU excelle dans l'exécution de ces multiplications matricielles d'une manière massivement parallèle. Il est également très efficace à partir d'un point de vue de l'utilisation de puissance, une qualité importante sur les appareils alimentés par batterie.

À chaque couche de ce réseau d'avance, la NPU calcule à la fois la sortie du neurone brut et la Fonction d'activation ReLu efficacement et avec une très faible latence. En tirant parti de l'ample mémoire à grande vitesse sur la NPU, il effectue ces calculs en parallèle sans avoir à payer le coût du transfert de données (c.-à-d., ralentir les performances) entre le CPU et le NPU.

Une fois que la couche finale de ce réseau d'avance profonde est calculée, le système a une représentation riche de la phrase de langue source. Cette représentation est ensuite alimentée par un «décodeur» de gauche à droite LSTM pour produire chaque mot de langue cible, avec le même algorithme d'attention utilisé dans la version en ligne de la NMT.

Comme Anthony AUE, un ingénieur principal du développement logiciel de l'équipe Microsoft Translator explique: «prendre un système qui fonctionne sur des serveurs Cloud puissants dans un centre de données et de l'exécuter inchangé sur un téléphone mobile n'est pas une option viable. Les appareils mobiles ont des limitations dans la puissance de calcul, la mémoire et l'utilisation de l'alimentation que les solutions Cloud n'ont pas. Ayant accès à la NPU, ainsi que d'autres ajustements architecturaux, nous a permis de contourner plusieurs de ces limitations et de concevoir un système qui peut fonctionner rapidement et efficacement sur l'appareil sans avoir à compromettre la qualité de la traduction."

La mise en œuvre de ces modèles de traduction sur le chipset NPU innovant a permis à Microsoft et Huawei de fournir une traduction neuronale sur l'appareil à une qualité comparable à celle des systèmes basés sur le Cloud, même lorsque vous êtes hors de la grille.