マイクロソフトの翻訳者とエッジデバイスに AI 翻訳をもたらす

11月2016で、マイクロソフトは、開発者とエンドユーザーに同様に、AI を搭載した機械翻訳、別名ニューラル機械翻訳 (NMT) の利点をもたらしました。先週です マイクロソフトは、クラウドのエッジに NMT 機能をもたらしました NPU を活用することで、AI 専用プロセッサを メイト10、Huawei 社の最新の主力電話です。この新しいチップは、インターネットアクセスがない場合でも、AI を搭載した翻訳をデバイス上で利用できるようにし、オンラインシステムと同等の品質の翻訳をシステムが生成できるようにします。

このブレークスルーを達成するために、マイクロソフトと Huawei 社の研究者とエンジニアは、この新しいコンピューティング環境にニューラル翻訳を適応させることに協力しました。

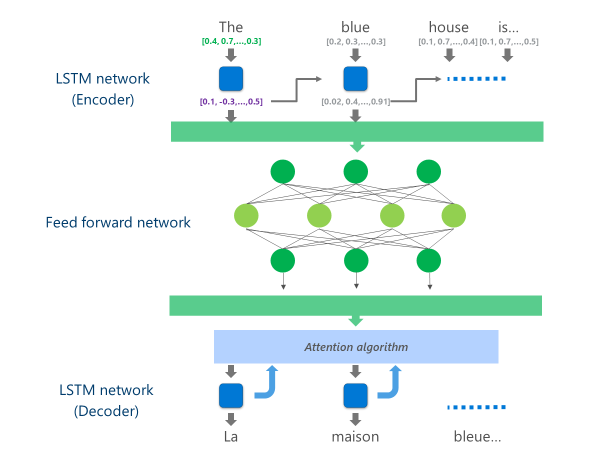

現在生産中の最も先進的な NMT システム (すなわち、企業やアプリケーションによってクラウドの規模で使用されている) は、複数のレイヤを組み合わせたニューラルネットワークアーキテクチャを使用しています。 LSTM ネットワーク、アテンションアルゴリズム、および変換 (デコーダー) レイヤーがあります。

以下のアニメーションは、この多層ニューラルネットワークがどのように機能するかを簡単な方法で説明しています。詳細については、「機械翻訳ページとは"マイクロソフトの翻訳サイトにあります。

このクラウド NMT 実装では、これらの中間 LSTM 層がコンピューティング能力の大部分を消費します。モバイルデバイスで完全な NMT を実行できるようにするには、可能な限り翻訳品質を維持しながら、これらの計算コストを削減できるメカニズムを見つける必要がありました。

これは、Huawei 社のニューラルプロセッシングユニット (NPU) が登場する場所です。 マイクロソフトの研究者とエンジニアは、特に低レイテンシの AI 計算で excel に設計された NPU を利用して、メイン CPU で処理するのが許容できないほど遅い操作を軽減しました。

実装

Huawei Mate 10 のためのマイクロソフトの翻訳アプリで利用できるようになりました実装は、NPU に最もコンピューティング集中型のタスクをオフロードすることによって変換を最適化します。

具体的には、この実装はディープ f によってこれらの中間 LSTM ネットワークレイヤを置き換えますeed ニューラルネットワーク.ディープフィードフォワードニューラルネットワークは強力ですが、ニューロン間の高い結合性のために非常に大量の計算を必要とします。

ニューラルネットワークは、主にマトリックス乗算に依存しており、数学的な観点から複雑ではないが、そのような深層神経回路網に必要なスケールで実行されると非常に高価である操作である。Huawei 社の NPU は、超並列方式でこれらのマトリックス乗算を行うことに優れています。また、電力利用の観点からも非常に効率的であり、バッテリ駆動デバイスの重要な品質です。

このフィードフォワードネットワークの各層では、NPU は生のニューロン出力と後続の ReLu 活性化機能 非常に低いレイテンシで効率的に。NPU の十分な高速メモリを活用することによって、CPU と NPU 間のデータ転送 (すなわち、パフォーマンスの低下) のためのコストを支払わなくても、これらの計算を並列で実行します。

このディープフィードフォワードネットワークの最終層が計算されると、システムはソース言語文の豊富な表現を持っています。この表現は、NMT のオンラインバージョンで使用される同じ注意アルゴリズムで、各ターゲット言語の単語を生成するために、左から右への LSTM 「デコーダ」を介して供給されます。

As アンソニー・ Aue、マイクロソフトの翻訳チームの主要なソフトウェア開発エンジニアが説明します。データセンターの強力なクラウドサーバー上で稼働し、携帯電話でそのまま実行するシステムは、現実的な選択肢ではありません。モバイルデバイスには、クラウドソリューションにはないコンピューティング能力、メモリ、および電力使用量に制限があります。NPU へのアクセスを他のいくつかのアーキテクチャの調整と共に使用することで、これらの制限の多くを回避し、翻訳品質を損なうことなく、デバイス上で迅速かつ効率的に実行できるシステムを設計することができました。."

これらの翻訳モデルを革新的な NPU チップセットに実装することで、Microsoft と Huawei 社は、グリッドをオフにしているときでも、クラウドベースのシステムと同等の品質でデバイス上のニューラル翻訳を提供できるようになりました。