마이크로 소프트 번역기로 가장자리 장치에 AI 번역을 현실로

11 월 2016, 마이크로소프트는 인공 지능 기계 번역의 혜택을 가져왔다, 일명 뉴 럴 머신 번역 (nmt), 개발자와 최종 사용자 모두에 게. 지난주 마이크로소프트는 클라우드 가장자리에 nmt 기능을 가져왔다 npu를 활용 하 여 AI 전용 프로세서가 통합 된 메이 트 10, 화 웨이의 최신 주력 전화. 새로운 칩은 인터넷 접속이 없어도 장치에서 AI 기반 번역을 사용할 수 있게 하 여 시스템에서 온라인 시스템과 동등한 품질의 번역을 생성할 수 있도록 합니다.

이러한 혁신을 달성 하기 위해 Microsoft와 Huawei의 연구원 및 엔지니어는이 새로운 컴퓨팅 환경에 신경 번역을 적용 하는 데 협력 했습니다.

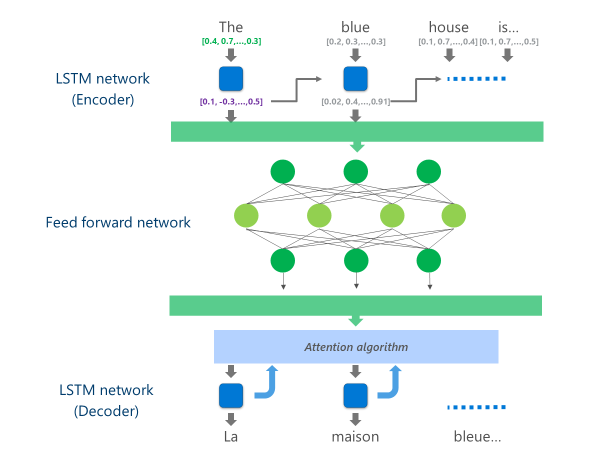

현재 생산 중인 가장 진보 된 nmt 시스템 (즉, 기업 및 앱에 의해 클라우드에서 대규모로 사용 되는)은 여러 계층을 결합 한 신경망 아키텍처를 사용 하 고 있습니다. lstm 네트워크, 주의 알고리즘 및 변환 (디코더) 계층을 제공 합니다.

아래의 애니메이션은이 멀티 레이어 신경망이 어떻게 기능 하는지를 간단한 방법으로 설명 합니다. 자세한 내용은 "기계 번역 페이지 란 무엇입니까?"마이크로 소프트 번역기 사이트에서.

이 클라우드 nmt 구현에서 이러한 중간 lstm 계층은 컴퓨팅 파워의 상당 부분을 소비 합니다. 모바일 장치에서 전체 nmt를 실행할 수 있으려면 번역 품질을 최대한 유지 하면서 이러한 계산 비용을 줄일 수 있는 메커니즘을 찾아야 했습니다.

이것은 Huawei의 신경 처리 장치 (npu)가 재생 되는 곳입니다. Microsoft 연구원 및 엔지니어는 주 CPU에서 처리할 수 없을 만큼 느리게 작동 하는 작업을 오프 로드 하기 위해 낮은 대기 시간 AI 계산에서 excel 하도록 특별히 설계 된 npu를 활용 했습니다.

구현

화 웨이 메이 트 10에 대 한 마이크로 소프트 번역기 응용 프로그램에서 사용할 수 있는 구현은 npu에 가장 계산 집약적 인 작업을 오프 로드 하 여 번역을 최적화 합니다.

특히이 구현은 이러한 중간 lstm 네트워크 계층을 딥 f로 대체 합니다.니드 포워드 신경망. 깊은 피드 포워드 신경망은 강력 하지만 뉴런 간의 높은 연결성으로 인해 매우 많은 양의 계산이 필요 합니다.

신경망은 수학적 관점에서 복잡 하지는 않지만 이러한 심층 신경망에 필요한 규모로 수행 되는 경우 매우 비용이 많이 드는 작업 인 행렬 곱셈에 주로 의존 합니다. Huawei npu는 대량 병렬 방식으로 이러한 매트릭스 곱셈을 수행 하는 것이 뛰어납니다. 전력 이용률 관점에서 볼 때, 배터리 구동식 장치에서 중요 한 품질에도 매우 효율적입니다.

이 피드 포워드 네트워크의 각 레이어에서 npu는 원시 뉴런 출력과 후속 relu 활성화 기능 매우 낮은 대기 시간으로 효율적으로. npu의 충분 한 고속 메모리를 활용 하 여 CPU와 npu 간의 데이터 전송 비용 (즉, 성능 저하)을 지불 하지 않고 병렬로 이러한 계산을 수행 합니다.

이 깊은 피드 포워드 네트워크의 최종 계층이 계산 되 면 시스템은 소스 언어 문장을 풍부 하 게 표현 합니다. 그런 다음이 표현은 왼쪽에서 오른쪽 lstm "디코더"를 통해 공급 되어 nmt의 온라인 버전에서 사용 되는 것과 동일한 주의 알고리즘으로 각 대상 언어 단어를 생성 합니다.

으로 앤서니 아우에Microsoft 번역사 팀의 주요 소프트웨어 개발 엔지니어가 다음을 설명 합니다.데이터 센터의 강력한 클라우드 서버에서 실행 되 고 휴대폰에서 변경 되지 않은 상태로 실행 되는 시스템을 수행 하는 것은 실용적인 옵션이 아닙니다. 모바일 장치에는 클라우드 솔루션에 없는 컴퓨팅 성능, 메모리 및 전력 사용량이 제한 됩니다. 다른 아키텍처 조정과 함께 npu에 대 한 액세스를 통해 이러한 제한 사항을 해결 하 고 번역 품질을 손상 시 키 지 않고도 장치에서 빠르고 효율적으로 실행할 수 있는 시스템을 설계 하는 데 도움이 되었습니다.."

혁신적인 npu 칩셋에 이러한 번역 모델을 구현 함으로써 Microsoft와 Huawei는 사용자가 그리드에서 떨어져 있어도 클라우드 기반 시스템에 필적 하는 품질로 온 디바이스 신경 번역을 제공할 수 있었습니다.